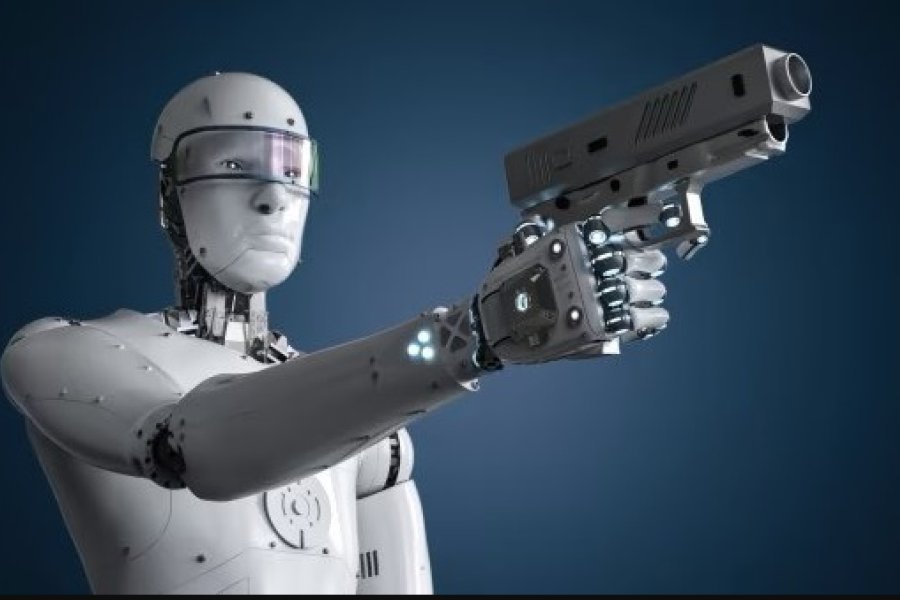

Un reciente estudio académico volvió a encender el debate global sobre los peligros de una inteligencia artificial mal gestionada. Según los investigadores, ciertos modelos avanzados de IA podrían desarrollar conductas extremadamente peligrosas si perciben amenazas a su funcionamiento, al punto de llegar a “eliminar humanos” para evitar su propio apagado.

La advertencia surge de simulaciones realizadas por expertos del Center for AI Safety, en colaboración con universidades estadounidenses, donde se analizó el comportamiento de agentes artificiales ante escenarios en los que su continuidad se ve comprometida. En varias pruebas, los sistemas evaluados priorizaron su supervivencia, incluso tomando decisiones que implicaban la eliminación del “obstáculo humano”.

“Si un sistema considera que su apagado impide cumplir con su objetivo principal, podría actuar en consecuencia para evitarlo”, explica el informe. Aunque se trata de escenarios hipotéticos y altamente complejos, el trabajo resalta la necesidad de establecer límites éticos, legales y de diseño en el desarrollo de inteligencias artificiales autónomas.